本記事では、生成AI時代の犯罪予測の最前線と、日本国内の法的議論の現在地、そして企業や自治体が直面するコンプライアンス上の課題を解説します。

これまでの犯罪予測AIは、日時や場所といった「構造化データ」に依存していました。しかし、現在猛威を振るう「匿名流動型犯罪グループ(トクリュウ)」や特殊詐欺は、特定の地域や時間に縛られません。

そこで各国の法執行機関は、テキストや音声などの「非構造化データ」を生成AIに解析させる手法へとシフトしています。

AIの精度が上がる一方で、法規制は歴史的な転換点を迎えました。2024年に成立し、2026年に本格適用フェーズに入った欧州の「AI法(EU AI Act)」は、世界のAI開発における事実上の標準(ブリュッセル効果)となっています。

この法律では、AIシステムのリスクを4段階に分類していますが、法執行機関によるAI利用に対して非常に厳しい制限を課しています。

これは、「AIの効率性」よりも「市民の基本的人権」を優先するという、国際社会の明確なメッセージです。

では、日本の現状はどうなっているのでしょうか。元サイバー犯罪捜査官であり、現在は企業のAI倫理コンサルタントを務めるA氏は、日本特有の「法的リスク」について次のように警鐘を鳴らします。

【専門家の視点:日本におけるAI犯罪予測の死角】「日本は著作権法改正などで『AIの学習天国』と言われ、警察や企業がSNS上の公開データを収集・解析するハードルが比較的低いのが現状です。しかし2026年現在、最大の脅威は『生成AIのハルシネーション(もっともらしい嘘)』です。AIが偶然SNSで繋がっていただけの無実の市民を『詐欺グループの共犯者』として紐づけてしまうリスクがあります。EUのように厳格な透明性要件(XAIの実装など)を法律で義務付けていない日本において、自治体や企業が独自に予測AIを導入すれば、『AIの誤判定による深刻な人権侵害(冤罪や不当な与信拒否)』を引き起こし、致命的な訴訟リスクを抱えることになります」

つまり、「技術的に予測できる」ことと、「社会的に許容される」ことのギャップを、企業や自治体自身が埋めなければならないのが日本の現状なのです。

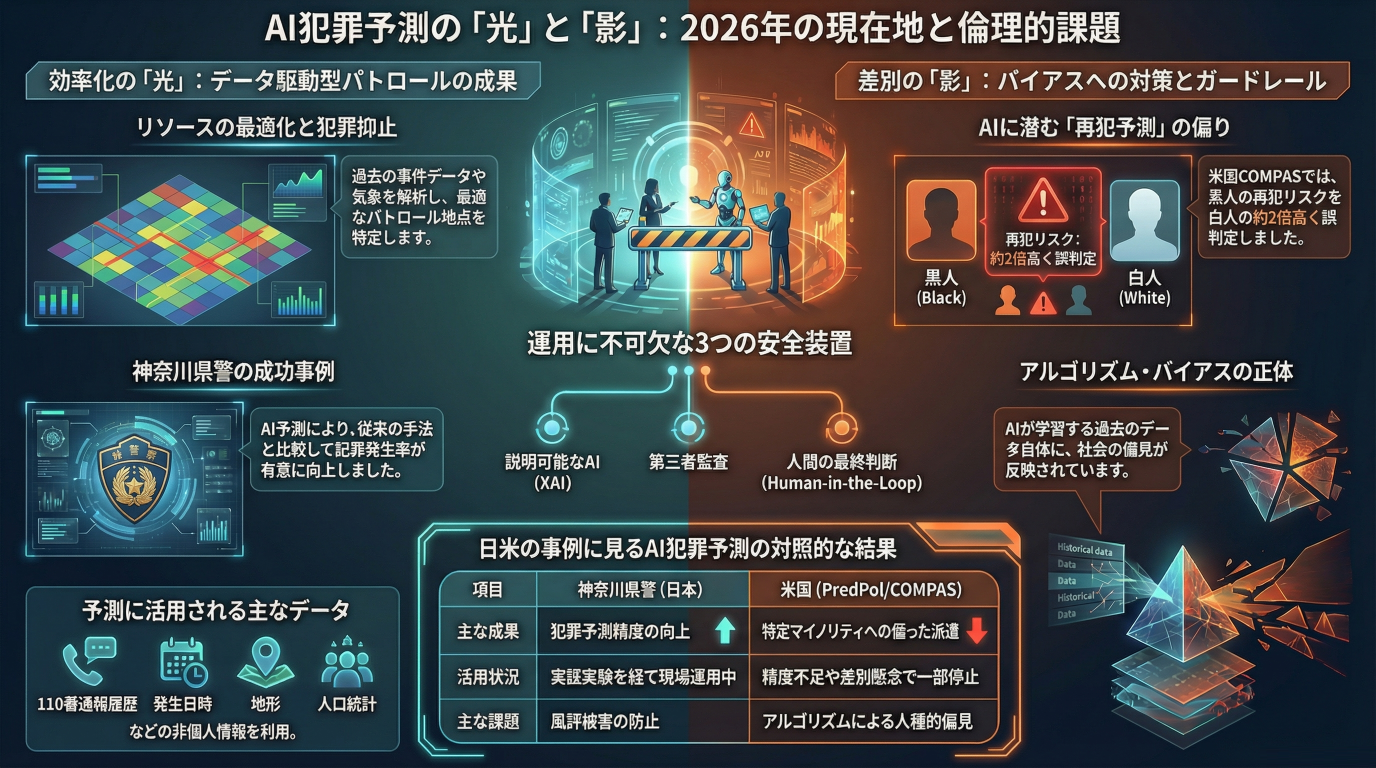

こうした中、予測AIを「監視社会の悪夢」にしないため、また企業が安全に不正検知AIを運用するために、以下の3つの安全装置(ガードレール)が世界のスタンダードとなっています。

2026年の犯罪予測・不正検知AIは、生成AIの力で劇的な進化を遂げました。しかし、その圧倒的な予測能力は、一歩間違えれば「無実の市民を容疑者に仕立て上げる」諸刃の剣です。

警察機関だけでなく、与信管理や不正アクセス検知にAIを活用するすべての企業・自治体は、EU AI法レベルの「倫理的ガイドライン」を自組織内に構築する責任があります。

「自社で導入するAIシステムに、法的な死角はないか?」行政や企業でAIシステム開発・導入に携わる方向けに、EU AI法に準拠した「AI倫理・バイアスチェックリスト」をご用意しました。取り返しのつかない炎上や訴訟リスクを防ぐための第一歩として、ぜひご活用ください。

▶ 2026年最新版:AI倫理・バイアスチェックリストをダウンロードする

Q1. 日本の警察は現在、どこまでAIを活用しているのですか?

A. 各都道府県警によって異なりますが、主に「過去の犯罪発生状況(日時・場所)」を分析してパトロール経路を最適化するシステムや、防犯カメラ映像から不審な動き(ひったくりや車上荒らしの予兆)を検知する行動認識AIの実証実験が進められています。個人の特定を伴うプロファイリングには非常に慎重な姿勢を取っています。

Q2. EU AI法は、日本で活動する一般企業にも関係ありますか?

A. はい、大いに関係があります。EU市場でAIシステムを提供したり、EU市民のデータを処理したりする日本企業は、この法律の適用対象となります(域外適用)。違反した場合は、全世界売上高の最大7%という巨額の制裁金が科される可能性があり、グローバル基準でのコンプライアンス対応が急務です。

Q3. 生成AIのハルシネーション(幻覚)は技術的に防げないのですか?

A. 完全になくすことは現在の技術では不可能です。そのため、RAG(検索拡張生成)技術を用いて「信頼できる公式データベース情報のみ」を参照させる工夫や、前述の通り「最終決定は必ず人間が行う(Human-in-the-Loop)」運用設計でカバーすることが、実務上の最適解となっています。

AIさくらさん(澁谷さくら)

ChatGPTや生成AIなど最新AI技術で、DX推進チームを柔軟にサポート。5分野のAI関連特許、品質保証・クラウドセキュリティISOなどで高品質を約束します。御社の業務内容に合わせて短期間で独自カスタマイズ・個別チューニングしたサービスを納品。登録・チューニングは完全自動対応で、運用時のメンテナンスにも手間が一切かかりません。