本記事では、ネット上の綺麗な成功事例ではなく、実際に私が支援した企業で起きた「ハルシネーションによる誤発注未遂」などの失敗談を交え、2025年現在の最適解となる「社内ガイドライン雛形」と「反対勢力の説得材料」を泥臭く解説します。

・「禁止」こそが最大のリスクである理由

・【実録コラム】本当にあった「AIトラブル」事例

・【コピペOK】社内利用ガイドライン雛形(2025年版)

・【実名NGですが…】支援先企業の「泥臭い」導入・改善事例

・社内の「反対勢力」をどう説得するか?

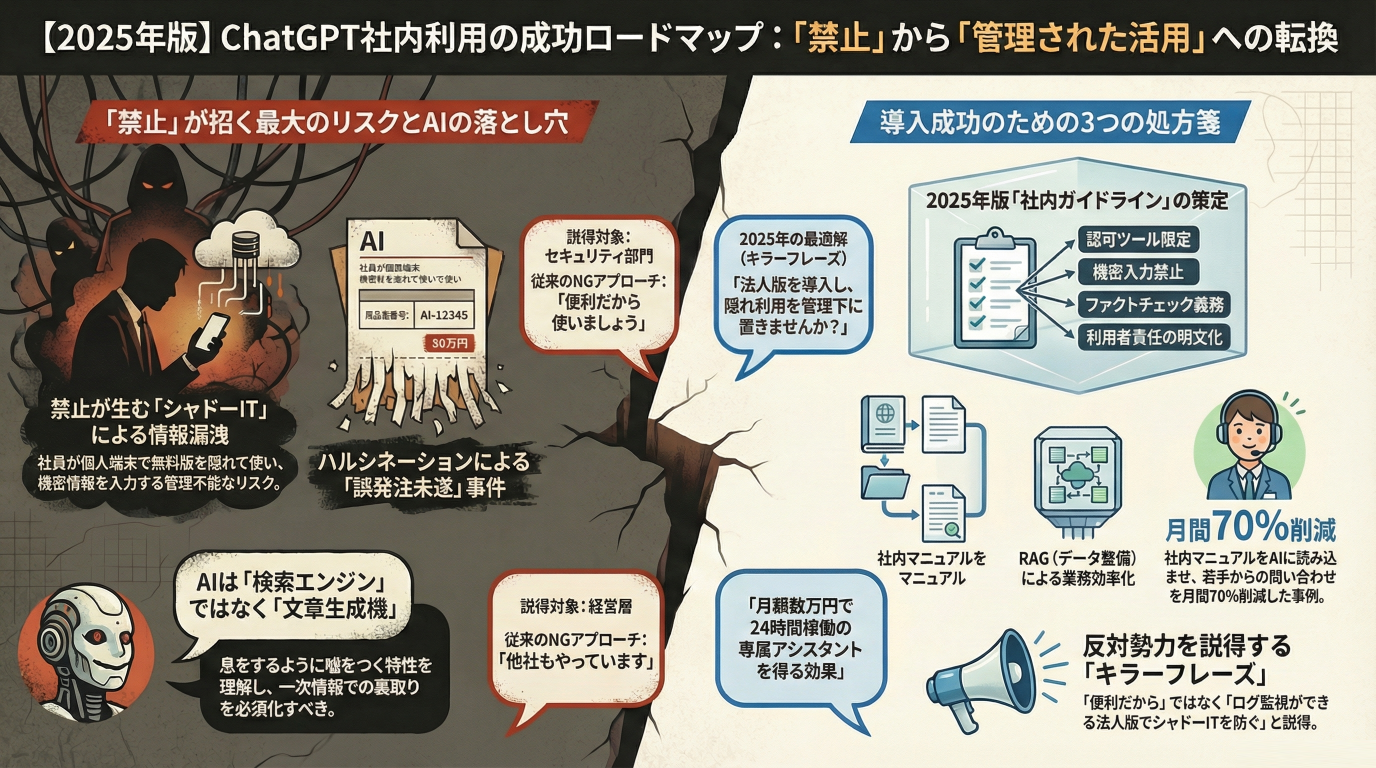

かつては「セキュリティ懸念」から禁止する企業も多くありましたが、現在は潮目が変わりました。禁止することで逆に発生するリスク(シャドーIT)の方が、経営にとって致命的だからです。

会社がツールを提供しない場合、社員は個人のスマホや自宅PCで無料版ChatGPTを使い、業務データを入力してしまいます。私が監査に入ったある企業では、「禁止されているから」という理由で、社員が議事録を個人のGoogleアカウントに転送し、自宅でChatGPTにかけて要約していた事例がありました。これこそが管理不能な情報漏洩です。

「会社が安全な環境を用意し、監視下で使わせる」ことが、唯一の防衛策です。

ガイドラインを作る前に、AIのリスクを正しく恐れる必要があります。実際に起きた「ヒヤリハット」を共有します。

製造業の購買担当Aさんは、海外製部品の代替品を探すため、ChatGPTに「〇〇(部品名)の互換品リストを出して」と指示しました。AIはもっともらしい型番とスペックを表形式で回答。Aさんはそれを信じ、50万円分の発注書を作成してしまいました。承認直前に上司がメーカーサイトを確認したところ、その型番は存在しませんでした(ハルシネーション)。

教訓:AIは「検索エンジン」ではなく「文章生成機」です。息をするように嘘をつきます。「AIの出力結果を裏取り(ファクトチェック)せずに業務利用してはならない」という一文は、ガイドラインに必須です。

上記のリスクを踏まえ、実務で使える標準的なガイドライン条文を掲載します。

第〇条(生成AIの利用原則)

第〇条(出力結果の確認義務と責任)

第〇条(著作権への配慮)

新聞に載るような大企業の事例は参考になりません。ここでは中小・中堅企業のリアルな導入事例を紹介します。

課題: ベテラン社員が持つ膨大な商品知識が属人化し、若手が育たない。施策: 社内の商品マニュアル(PDF)をAIに読み込ませる「RAG環境」を構築。泥臭い工夫: 最初はAIが的外れな回答ばかりしたため、総務担当者が1ヶ月かけてマニュアルのファイル名を統一し、図表をテキスト化する「データ整備」を行いました。結果: 若手からベテランへの「これ何ですか?」電話が月間70%減少。

課題: コード生成での情報漏洩懸念。施策: API経由で「学習されない」チャットボットを自社開発。独自の工夫: 「入力欄に『株式会社』や『@』などの文字列が含まれると、アラートが出て送信できない」というフィルタリング機能を実装し、うっかりミスをシステム的に防ぎました。

導入担当者がぶつかる最大の壁は、セキュリティ部門や保守的な役員です。彼らを説得するための「キラーフレーズ」を授けます。

A. 情報の種類・利用方法によります。個人情報や機密データを含まない活用であれば問題ない場合が多いですが、セキュリティ対策と利用ルールの整備が必須です。

A. 一般的なFAQ応答や業務の定型的案内には非常に有効です。ただし、誤回答のチェック体制や、情報の最新性維持が前提です。

A. 利用前にガイドラインの共有・研修を行う、入力前に「これは機密か?」を確認させるUI設計を導入する、などが有効です。

ChatGPTの社内利用は、もはや「するかしないか」の議論ではありません。「いかに安全に、効果的に使うか」のフェーズに入っています。適切なガイドラインとシステム環境さえ整えれば、AIは社員の生産性を倍増させる最強のパートナーになります。

執筆:株式会社ティファナ・ドットコム AI活用推進チーム(生成AI/社内問い合わせ支援の実績多数)

監修:AIさくらさん開発部(25年以上のチャットボット開発実績、自治体・企業への導入多数)

提供ツール:社内問い合わせさくらさん(https://www.tifana.ai/products/aichatbot)

チャットボット運用に一切手間をかけず成果を出したい企業専用

AIさくらさん(澁谷さくら)

ChatGPTや生成AIなど最新AI技術で、DX推進チームを柔軟にサポート。5分野のAI関連特許、品質保証・クラウドセキュリティISOなどで高品質を約束します。御社の業務内容に合わせて短期間で独自カスタマイズ・個別チューニングしたサービスを納品。登録・チューニングは完全自動対応で、運用時のメンテナンスにも手間が一切かかりません。